728x90

SMALL

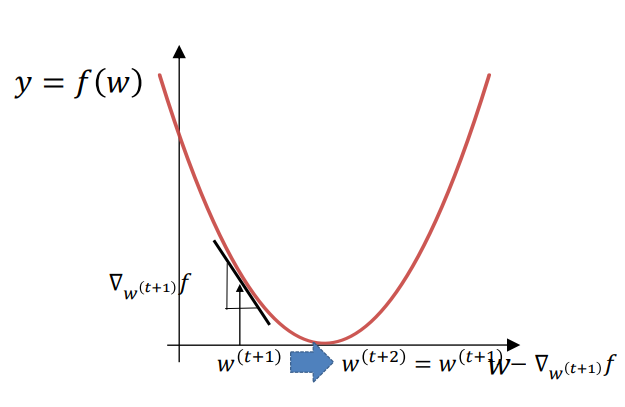

Gradient Descent

머신러닝과 딥러닝의 최적화 알고리즘으로, 손실 함수(loss function)를 최소화하여 모델의 성능을 개선하는 데 사용된다.

손실함수의 기울기를 계산하여 매개변수를 조정하는 최적화 방법이며 기울기의 최솟값을 찾는것을 목표로 한다.

Computation Graph

컴퓨터 알고리즘화 된 합성함수에 대한 미분 테크닉이 체인 룰!

예시로 시그모이드 함수를 생각하면 아래와 같다

기본 오퍼레이션이 node가 되고 그 input과 output이 edge가 된다.

어떤 합성함수든 그래프를 통해 표현만 된다면 계산가능하다!

Backpropagation

신경망의 학습 과정에서 오차를 전파하여 모델의 가중치를 최적화하는 알고리즘

- Forward propagation

주어진 입력으로 계산 그래프(=네트워크)의 출력을 계산 - Backpropagation

전체 오류에 기여하는 정도에 비례하여 네트워크의 모델 파라미터 조정

백워드 패스로 출력에서 입력 방향으로 가중치 업데이트

y_pred=model(X)

loss=loss_fn(y_pred,y) #Forward

.

.

.

loss.backward() #Backpropagation

728x90

LIST

'SKT FLY AI > Reinforcement Learning' 카테고리의 다른 글

| Reinforcement Learning(5) Temporal-Difference RL (0) | 2024.07.18 |

|---|---|

| Reinforcement Learning(4) Monte-Carlo RL (0) | 2024.07.17 |

| Reinforcement Learning (3) Markov Decision Process (0) | 2024.07.17 |

| Reinforcement Learning (1) Intro (2) | 2024.07.17 |